Hallo in die eckige Runde!

… letzte Nacht hatte ich mal meinen “Coder-Benchmark” (was aus meiner Diplomarbeit und Uni-Anfänger-Praktikum-Projekt Ende der '90-er) bei Grok ausprobiert.

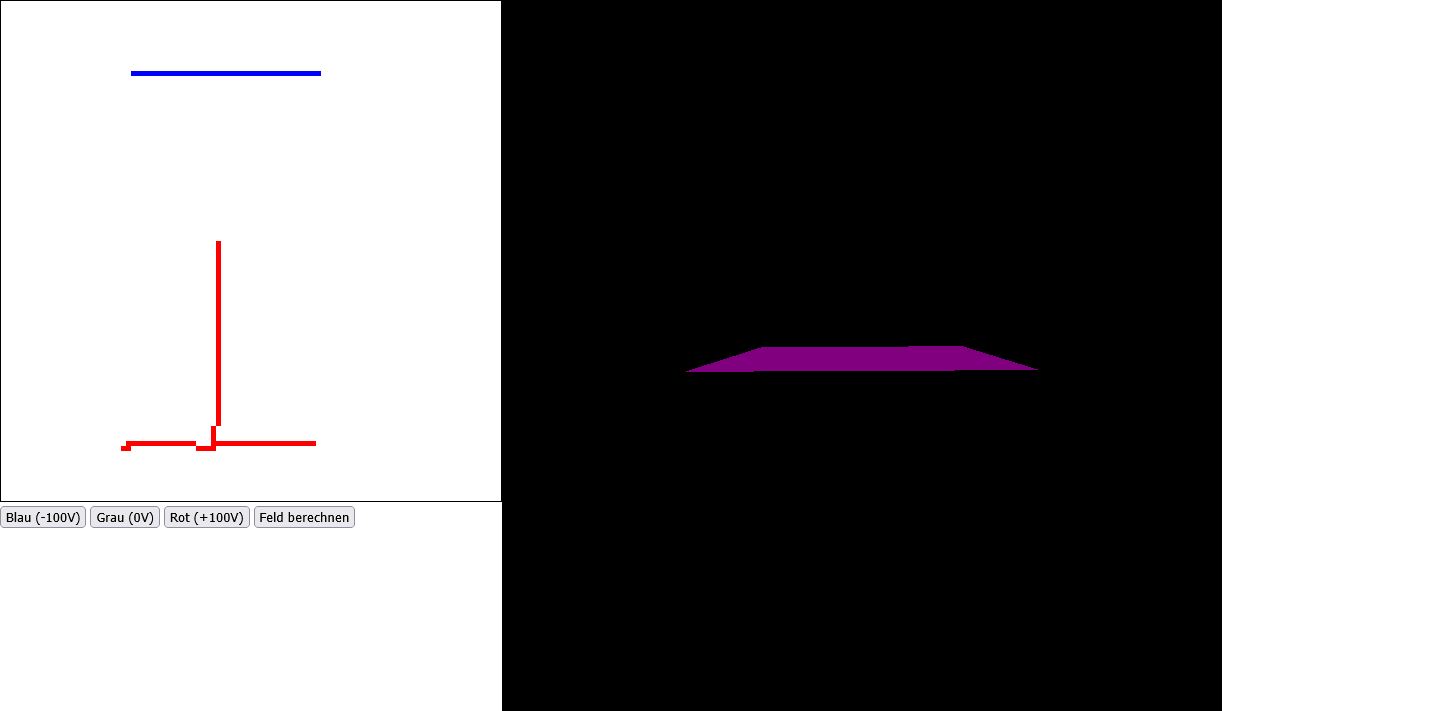

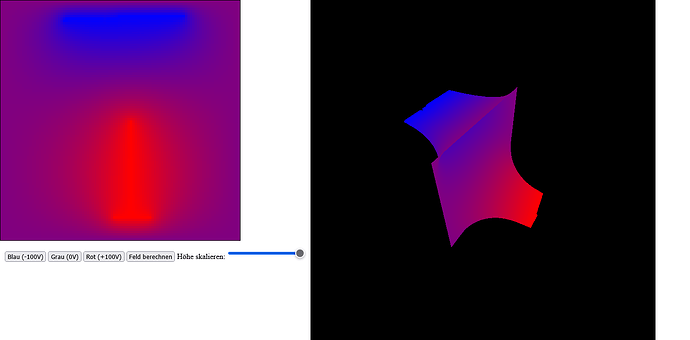

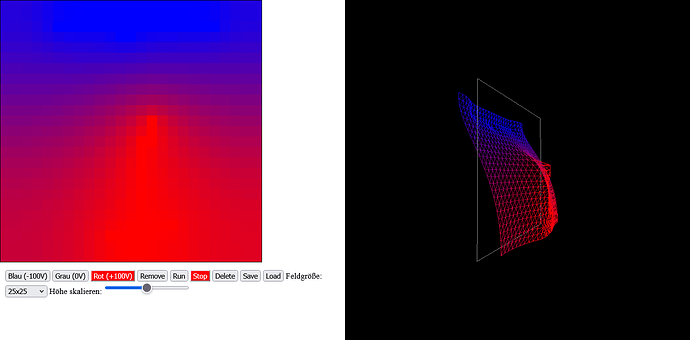

Hier mein erster Prompt mit dem Ergebnis nach 30 Sekunden:

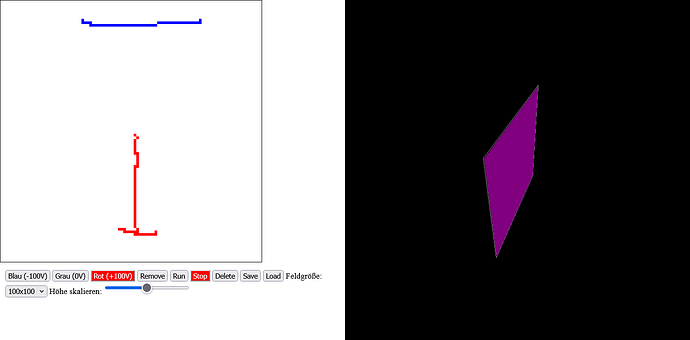

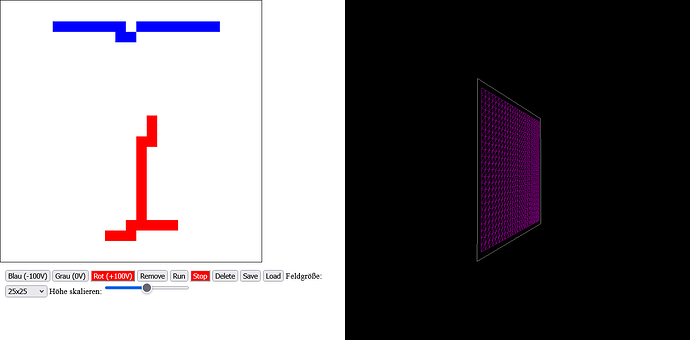

VDX: … kannst du ein Programm zur Ausführung im Firefox-Browser erstellen, in welchem ich mit der Maus mit 3 auswählbaren Farben für Elektroden (Blau = -100 Volt, Grau = 0 Volt, Rot = +100 Volt) Elektrodenkonturen auf eine 100x100 Einheiten große Fläche zeichne, und dann das Äquipotentialfeld zwischen diesen Elektroden und dem äußeren “frei mitlaifendem” Rand berechnet und in einem separaten Fenster als farbiges 3D-Objekt anhezeigt wird und mit der Maus im Raum gedreht werden kann?

(Grok: >>> Programmcode-1)

… hmmm – sieht man nicht so viel …

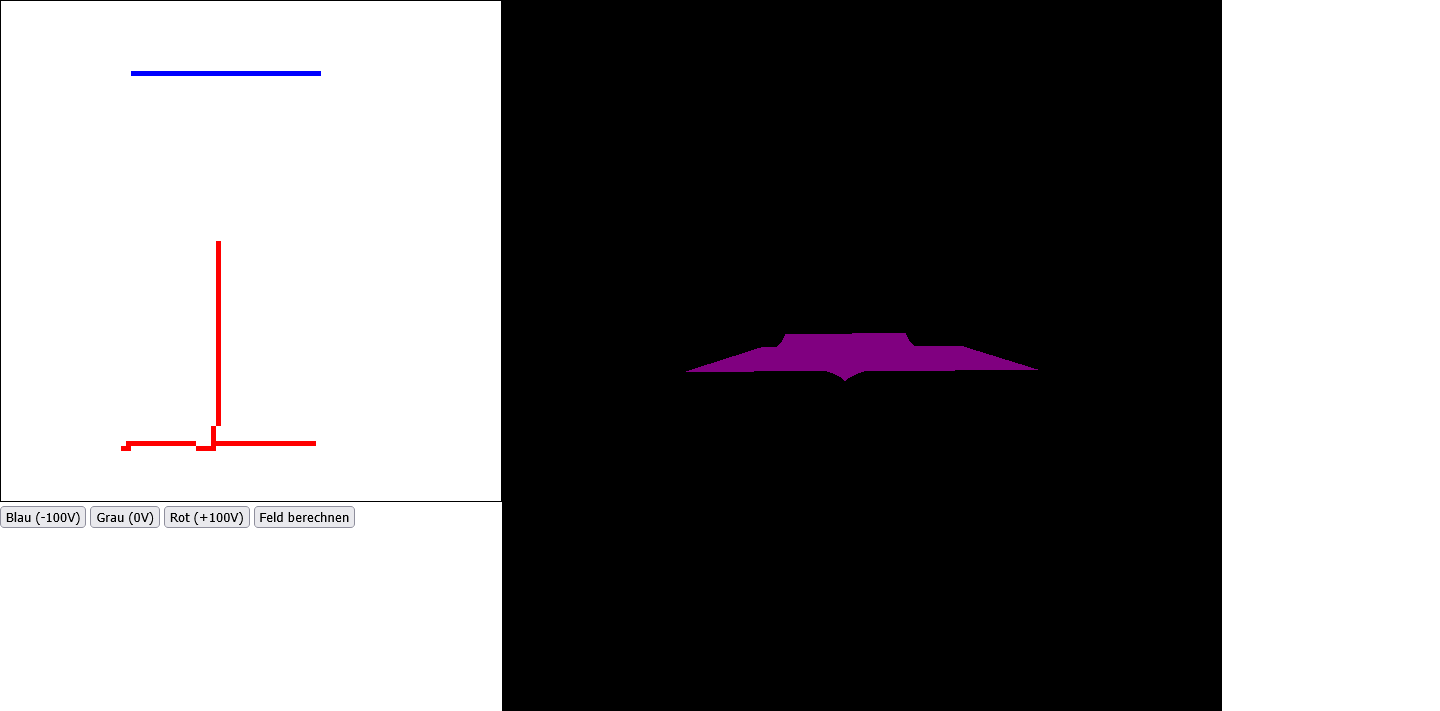

- Prompt mit Ergebnis:

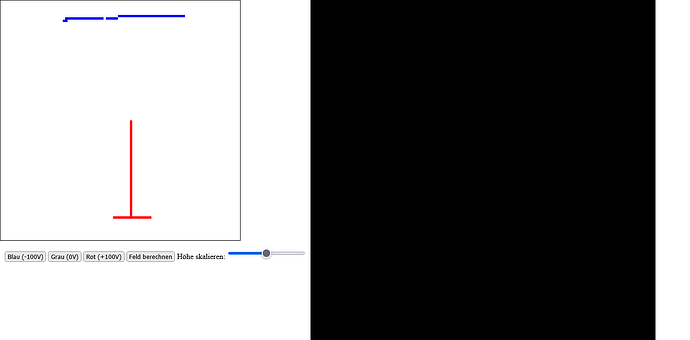

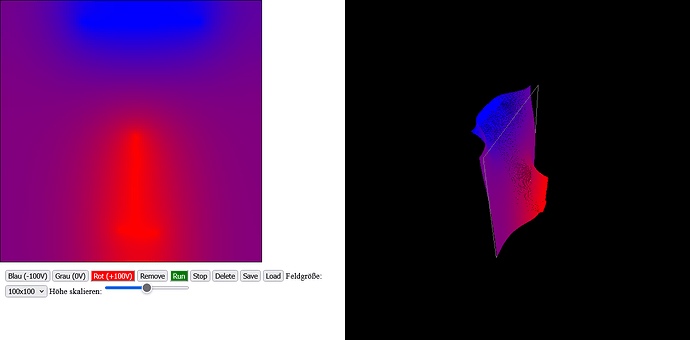

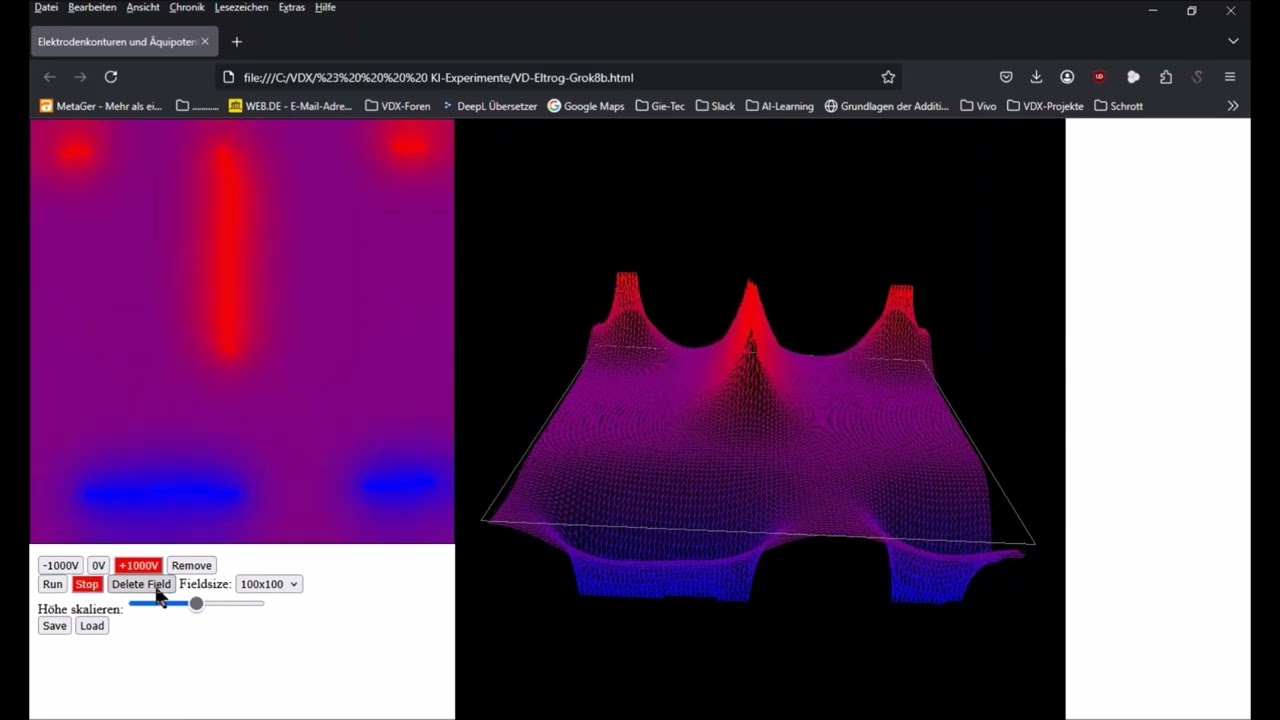

VDX: … kannst du die berechnete Fläche entsprechend dem jeweiligen Potential zwischen -100 Volt und +100 Volt mit dneFarbverläufen zwischen Blau (-100V9 und Rot (+100V) einfärben und die dargestellte Höhe mit einem Schieber am Rand variabel machen? Diesen Farbverlauf dann bitte auch im linken Fenster anzeigen

(Grok: >>> Programmcode-2)

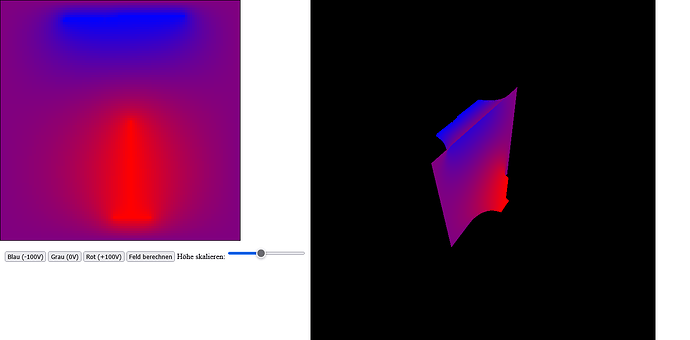

… nach ein paar weiteren Prompts (schon faszinierend, dabei zuzuschauen, wie das Äquipotentialfeld “live” berechnet/simuliert wird):

Das war jetzt für den Browser … auf Anfrage hat er mir das auch gleich nach Python konvertiert ![]()